Diseñado para maximizar la eficiencia y el rendimiento en inferencia

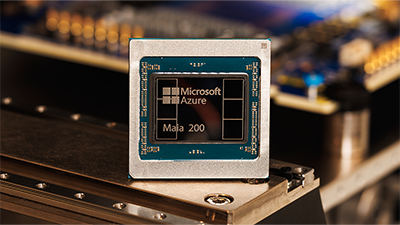

Microsoft presenta Maia 200, un acelerador de inferencia revolucionario diseñado para mejorar de manera importante la economía de la generación de tokens con IA. Maia 200 es una potencia en inferencia de IA: un acelerador construido sobre el proceso de 3nm de TSMC con núcleos tensoriales nativos FP8/FP4, un sistema de memoria rediseñado con 216GB HBM3e a 7 TB/s y 272MB de SRAM integrada, además de motores de movimiento de datos que mantienen los modelos masivos alimentados, rápidos y con una alta utilización. Esto convierte a Maia 200 en el silicio de primera mano más eficiente de cualquier hiperescalador, con tres veces el rendimiento FP4 del Amazon Train de tercera generación y un rendimiento FP8 superior al TPU de séptima generación de Google. Maia 200 es también el sistema de inferencia más eficiente que Microsoft ha desplegado jamás, con un 30% de rendimiento por dólar superior al hardware de última generación de nuestra flota actual.”

Maia 200 forma parte de la infraestructura de IA y servirá para múltiples modelos, incluidos los últimos modelos GPT-5.2 de OpenAI, para aportar una ventaja de rendimiento por dólar a Microsoft Foundry y Microsoft 365 Copilot. El equipo de Microsoft Superintelligence utilizará Maia 200 para la generación de datos sintéticos y el aprendizaje por refuerzo para mejorar los modelos internos de próxima generación. Para casos de uso de pipelines de datos sintéticos, el diseño único de Maia 200 ayuda a acelerar la velocidad a la que se pueden generar y filtrar datos de alta calidad y específicos de dominio, para alimentar la formación posterior con señales más frescas y específicas.

Maia 200 está desplegado en la región de centros de datos US Central, cerca de Des Moines, Iowa, con la región de centros de datos US West 3 cerca de Phoenix, Arizona, a continuación, y futuras regiones que vendrán después. Maia 200 se integra a la perfección con Azure, y presentamos el SDK de Maia con un conjunto completo de herramientas para construir y optimizar modelos para Maia 200. Incluye un conjunto completo de capacidades, incluida la integración con PyTorch, un compilador Triton y una biblioteca optimizada del kernel, así como acceso al lenguaje de programación de bajo nivel de Maia. Esto ofrece a los desarrolladores un control detallado cuando es necesario, al tiempo que facilita la portabilidad de modelos a través de aceleradores de hardware heterogéneos.

Fabricado con el avanzado proceso de 3 nanómetros de TSMC, cada chip Maia 200 contiene más de 140 mil millones de transistores y está adaptado para cargas de trabajo de IA a gran escala, además de ofrecer un rendimiento eficiente por dólar. Está diseñado para los modelos más recientes que utilizan computación de baja precisión, con cada chip Maia 200 que entrega más de 10 petaFLOPS en precisión de 4 bits (FP4) y más de 5 petaFLOPS de rendimiento de 8 bits (FP8), todo dentro de un envolvente TDP SoC de 750W. En términos prácticos, Maia 200 puede correr sin esfuerzo los modelos más grandes de hoy, con mucho margen para modelos aún más grandes en el futuro.

Leave a Reply